Aucun ordinateur quantique n’a encore pulvérisé une barrière infranchissable pour les machines classiques. Pourtant, la planète recherche s’agite : milliards investis, laboratoires publics et privés mobilisés, ambitions affichées. Le paradoxe frappe, ce rêve de puissance ne naît ni dans les ateliers de l’industrie, ni dans l’antre des ingénieurs, mais bien au cœur même de la physique théorique.

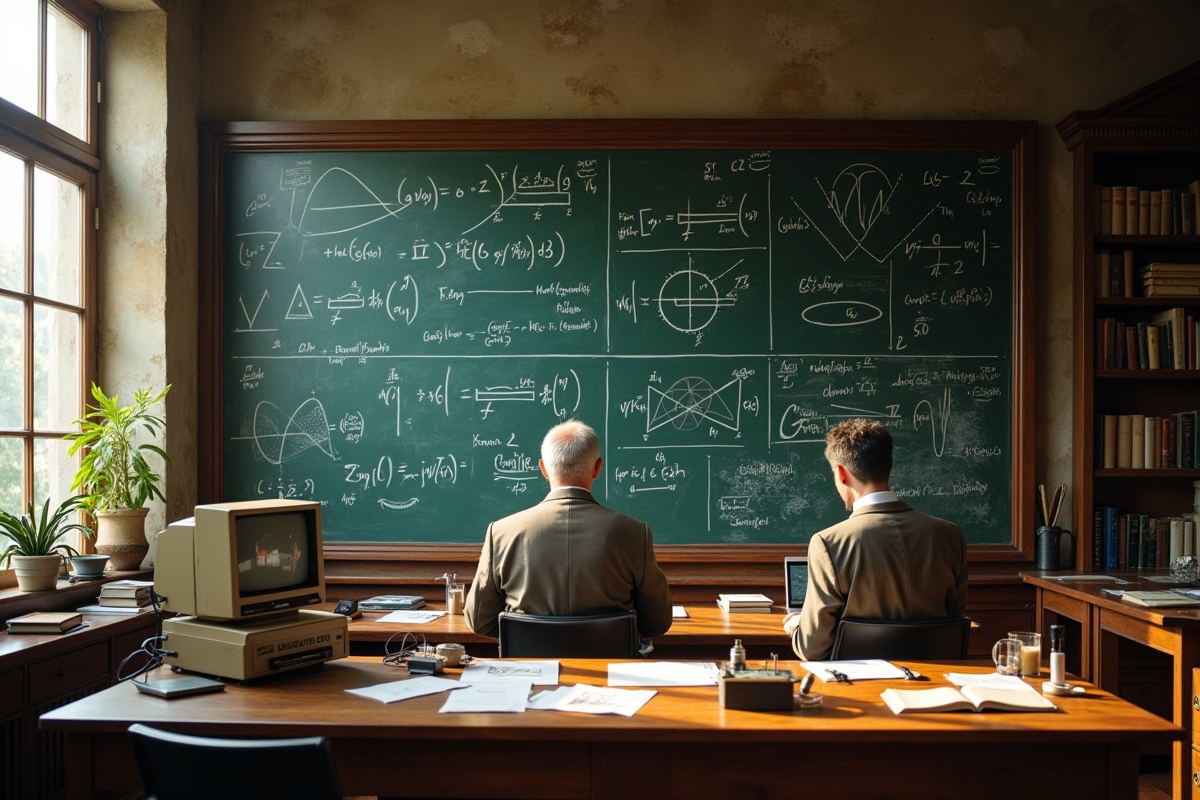

Depuis le début des années 1980, une poignée de chercheurs a posé les jalons d’un calcul qui n’obéit plus aux lois traditionnelles. Pas de prototype à l’époque, seulement des théories, des modèles mathématiques, des hypothèses posées sur papier. L’évolution ne suit pas la trajectoire d’un génie solitaire, mais ressemble à un chantier collectif, construit à coups d’intuitions et de confrontations d’idées.

L’ordinateur quantique, un rêve longtemps jugé impossible

À l’origine, l’ordinateur quantique n’est pas la réponse à une impasse technologique. Il surgit d’un défi lancé à la physique elle-même : la mécanique quantique pouvait-elle révolutionner la façon de traiter l’information ? Au début des années 1980, la machine de Turing règne sans partage, incarnant l’orthodoxie binaire des bits, 0 ou 1, rien d’autre. Mais quelques physiciens, curieux et parfois téméraires, osent pousser la réflexion plus loin et songent à exploiter la superposition des états quantiques pour démultiplier la puissance de calcul.

Le scepticisme est de mise. Contrôler des qubits, préserver leur délicate superposition, les protéger des perturbations extérieures ? L’idée semble irréalisable. Les premiers modèles ne quittent pas le domaine de la théorie, confinés à des équations complexes. Pourtant, l’espoir est là : certains problèmes mathématiques, hors de portée des ordinateurs classiques, pourraient être résolus en un clin d’œil par ces machines d’un genre nouveau.

Quarante ans plus tard, le chantier est loin d’être achevé. Des prototypes, l’IBM System One en tête, marquent la transition entre la théorie et l’expérimentation. IBM, Google, Microsoft et quelques autres misent gros pour franchir les dernières étapes. Mais chaque avancée met en lumière de nouveaux obstacles. La course au premier ordinateur quantique universel, capable de rivaliser avec les machines classiques sur le terrain de la polyvalence, reste ouverte. Aucun vainqueur à l’horizon, mais une compétition mondiale qui s’intensifie.

Qui sont les pionniers derrière l’invention de l’informatique quantique ?

L’histoire de l’ordinateur quantique ne se réduit pas à un seul nom, mais elle compte des pionniers. Richard Feynman, figure majeure de la physique, pose dès 1981 la question qui va faire basculer le débat : pourquoi ne pas simuler le comportement quantique avec des machines fondées sur la même logique ? L’idée fait son chemin. À Oxford, David Deutsch formalise en 1985 le concept d’ordinateur quantique universel : une machine de Turing revisitée, capable de manipuler la superposition et l’intrication, ces deux piliers de la physique quantique.

Au fil des années 1990, la théorie trouve ses premiers débouchés pragmatiques. Peter Shor met au point en 1994 un algorithme qui bouleverse la cryptographie : la factorisation de grands nombres, jusque-là inaccessible, devient soudainement envisageable. Deux ans plus tard, Lov Grover imagine une méthode pour accélérer la recherche dans des bases de données non structurées, une avancée qui fait date.

Des institutions prennent alors le relais, portées par la promesse d’applications inédites. Voici quelques acteurs majeurs qui s’illustrent dans la construction de cette nouvelle informatique :

- IBM et Google se livrent une bataille serrée pour mettre au point les premiers processeurs quantiques réellement exploitables.

- En France, le CEA progresse sur la piste des qubits supraconducteurs, une des technologies les plus prometteuses du secteur.

- Au Canada, l’Université de Sherbrooke s’impose comme un pôle de recherche reconnu dans l’écosystème quantique.

La dynamique impulsée par Feynman, Deutsch, Shor et Grover ne relève pas d’un parcours individuel. Physiciens, ingénieurs, informaticiens et mathématiciens unissent leurs efforts, rejoints aujourd’hui par les géants du secteur technologique, Amazon, Microsoft, et bien d’autres. L’informatique quantique s’est muée en aventure collective, où chaque percée redéfinit les contours du possible.

Comprendre les principes clés : superposition, intrication et qubits expliqués simplement

Pour cerner ce qui distingue l’ordinateur quantique, il faut commencer par les fondations : le qubit. Là où le bit classique hésite entre 0 et 1, le qubit, grâce à la superposition, peut adopter simultanément plusieurs valeurs. Cette propriété, issue de la physique quantique, démultiplie la capacité de calcul et change la donne.

L’intrication, ou entanglement, est une autre singularité remarquable. Deux qubits intriqués affichent des comportements parfaitement corrélés, même s’ils sont séparés par des kilomètres. Changer l’état de l’un agit instantanément sur l’autre, une étrangeté qui renforce la puissance du calcul quantique et pose les bases de communications sécurisées inatteignables pour le monde classique.

La mesure, elle, tranche. Tant qu’aucune observation n’est faite, le qubit reste indéfini, gouverné par des probabilités. Dès qu’on le mesure, il choisit son camp : 0 ou 1. Ce saut brutal du flou à la certitude est au cœur de la logique quantique, mais il complique sérieusement la vie des ingénieurs. Manipuler et préserver cet état quantique exige des conditions extrêmes, à commencer par des températures proches du zéro absolu.

Les concepts de la mécanique quantique, spin, états multiples, systèmes corrélés, s’invitent désormais dans la conception des ordinateurs. Chaque avancée technique repousse la frontière du calcul, chaque défi relevé dessine une nouvelle manière de penser la machine.

Pourquoi l’ordinateur quantique fascine et divise encore aujourd’hui

L’ordinateur quantique cristallise les passions et alimente les controverses. Sur le papier, les promesses sont vertigineuses : des algorithmes capables d’effectuer en quelques minutes ce qui demanderait des siècles à un ordinateur traditionnel. Les algorithmes de Shor et de Grover symbolisent cette rupture, offrant la perspective de casser des codes ou d’explorer d’immenses bases de données avec une rapidité inégalée. La sécurité des systèmes informatiques actuels, encore largement fondée sur la difficulté de ces opérations pour les machines classiques, se retrouve menacée.

Cependant, la réalité se montre plus nuancée. Entre enthousiasme débordant et prudence scientifique, les débats font rage. Certains voient dans l’informatique quantique la prochaine grande révolution, d’autres pointent la fragilité des qubits et les difficultés techniques pour stabiliser les états quantiques. Chaque annonce de nouveau record ou de prototype suscite un examen attentif. Derrière chaque prouesse, la même interrogation revient : s’agit-il d’une avancée généralisable ou d’une simple démonstration confinée à des cas particuliers ?

Les applications concrètes, elles, émergent lentement hors des laboratoires. La banque, la chimie, les télécommunications expérimentent la simulation de systèmes quantiques complexes, l’optimisation ou encore la cryptographie quantique. Mais déjà, la cryptographie post-quantique prépare la riposte, anticipant l’arrivée de ces machines capables de rompre les codes actuels. Au-delà de la technique, la compétition s’étend à l’échelle internationale : États-Unis, Europe, Chine investissent massivement, convaincus que la maîtrise de l’informatique quantique pourrait rebattre les cartes du pouvoir numérique.

Aujourd’hui, l’ordinateur quantique est à la croisée des chemins : ni utopie lointaine, ni réalité banale. Il continue de nourrir les ambitions, d’alimenter les doutes, et d’attiser la rivalité mondiale. Reste à savoir si la prochaine décennie verra l’avènement d’une machine qui bouleversera enfin notre rapport au calcul, ou si la révolution quantique restera, pour un temps encore, à portée de promesse.