La NASA parie sur des machines capables de débusquer des milliards de solutions en quelques secondes. Pourtant, ces prodiges technologiques peinent encore sur les opérations arithmétiques les plus simples, là où n’importe quel ordinateur familial excelle. Ce contraste frappe d’emblée : d’un côté, des performances hors norme, de l’autre, une maladresse sur les gestes quotidiens du numérique.

Au centre de cette contradiction, un bouleversement complet des règles établies. Les fondations de l’informatique, façonnées et perfectionnées au fil des décennies, se voient soudainement remises en cause, parfois même reléguées au second plan. Chaque nouvel algorithme porte en lui la promesse d’une accélération fulgurante… mais aussi la menace de rendre caducs certains remparts de sécurité que l’on croyait indépassables.

Ordinateur classique et ordinateur quantique : deux univers, deux manières de calculer

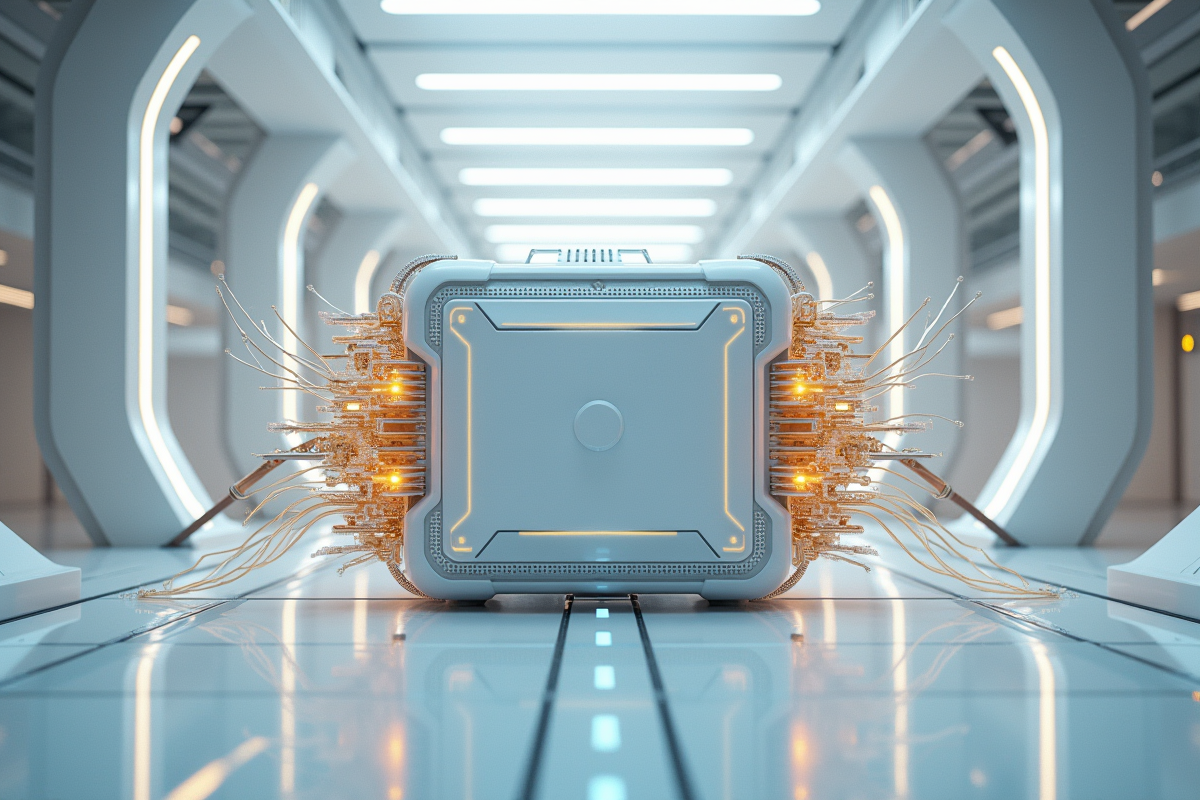

Un ordinateur classique repose sur une architecture familière : la logique binaire. Son outil de base, le bit, alterne entre 0 et 1. À l’intérieur de chaque machine, un orchestre de transistors orchestre des milliards de commutations, rassemblées dans le microprocesseur selon la fameuse architecture von Neumann. Ce modèle structure l’informatique traditionnelle. Les portes logiques manipulent les bits, exécutant des instructions les unes après les autres, à grande vitesse, mais en restant limitées par les propriétés physiques du silicium.

Face à cela, l’ordinateur quantique redistribue complètement les cartes. Sa brique élémentaire, le qubit, ne se contente pas d’un choix binaire. Grâce à la mécanique quantique, et des notions comme la superposition ou l’intrication, le qubit est capable d’exister dans plusieurs états à la fois. Un registre de n qubits peut ainsi traiter en parallèle des informations qui exigeraient des années de calcul à une machine classique. Voilà où se situe la vraie différence entre ordinateur normal et ordinateur quantique : l’un manipule le certain, l’autre l’incertitude et le probabilisme.

Les portes quantiques, quant à elles, remplacent les circuits logiques classiques. Elles transforment l’état des qubits en exploitant la physique quantique, via la décohérence ou l’interférence. Ce calcul quantique ne fait pas qu’accélérer les calculs : il permet de résoudre des problèmes inaccessibles au monde classique, comme la modélisation de systèmes complexes ou l’optimisation à grande échelle.

D’un côté, la fiabilité et la répétitivité des ordinateurs classiques ; de l’autre, la force brute et la vulnérabilité des machines quantiques, encore sensibles aux erreurs et à l’environnement extérieur. Ce fossé n’est pas anodin : il esquisse les contours du futur de l’informatique et redéfinit ses usages.

Comment fonctionne un ordinateur quantique ? Explications concrètes

Le fonctionnement des ordinateurs quantiques gravite autour d’un concept révolutionnaire : le qubit. À la différence du bit classique, cantonné à 0 ou 1, le qubit utilise la superposition. Résultat : un seul qubit peut représenter 0, 1 ou n’importe quelle combinaison des deux. Cette propriété sous-tend la puissance du calculateur quantique, permettant des calculs simultanés d’une ampleur inédite.

La mécanique quantique ajoute une corde à son arc : l’intrication. Deux qubits intriqués restent corrélés, quelle que soit la distance qui les sépare. C’est ce qui rend possibles des algorithmes quantiques spectaculaires, comme l’algorithme de Shor (pour la factorisation) ou celui de Grover (pour la recherche dans des bases de données non structurées).

Pour façonner ces calculs, le processeur quantique s’appuie sur différentes technologies. Voici les principales approches développées aujourd’hui :

- Supraconducteurs : circuits refroidis à des températures frôlant le zéro absolu

- Ions piégés : atomes maintenus et manipulés par des champs électromagnétiques

- Photons : particules de lumière guidées dans des circuits optiques

- Atomes froids : utilisation d’atomes neutres contrôlés par laser

Les algorithmes quantiques doivent cependant composer avec la grande fragilité des qubits. Corriger les erreurs reste l’un des plus grands défis techniques. Aujourd’hui, les machines dites NISQ (Noisy Intermediate-Scale Quantum) sont encore marquées par le bruit, les erreurs de mesure et l’instabilité. La capacité à augmenter le nombre de qubits, la fameuse scalabilité, dépendra largement de la maîtrise de ces obstacles.

Pourquoi l’informatique quantique bouleverse la sécurité numérique

Le calcul quantique met la cryptographie actuelle sous pression. Les protocoles qui protègent nos échanges sur internet, comme le RSA ou l’ECDSA, reposent sur des calculs réputés impossibles à résoudre rapidement pour un ordinateur classique. Multiplier deux grands nombres premiers ? Facile. Les factoriser ? Un casse-tête qui prendrait des dizaines de milliers d’années… sauf pour un ordinateur quantique doté de l’algorithme de Shor. Là, la perspective de casser ces codes devient tangible, et non plus un simple scénario théorique.

Cette évolution chamboule la cybersécurité. Les spécialistes développent déjà des algorithmes post-quantiques, pensés pour résister à la puissance des calculateurs quantiques. Mais basculer vers ces nouveaux protocoles demande du temps et des efforts considérables. Les réseaux, les banques, les organismes publics : tout l’écosystème numérique doit se réinventer face à cette avancée.

La recherche avance, expérimente, propose des alternatives. Des protocoles inédits voient le jour, fondés sur des problèmes mathématiques que l’on estime résistants à l’assaut du quantique. Mais une menace silencieuse grandit : la stratégie du « store now, decrypt later ». Certains collectent déjà des données chiffrées, pariant qu’un futur calculateur quantique permettra un jour de les décrypter. Dans ce contexte, la vigilance s’impose comme un impératif pour préserver la fiabilité de nos infrastructures numériques.

Ce que le quantique va changer pour l’informatique de demain

Le calcul quantique a quitté les laboratoires pour entrer dans la course industrielle. Google, IBM, les gouvernements français ou chinois : tous investissent dans la prochaine génération de calculateurs. Cette fois, il ne s’agit pas seulement de vitesse, mais de transformer la nature même des problèmes abordés. Les ordinateurs quantiques promettent de s’attaquer à des problèmes NP-complets, à l’optimisation, à la simulation moléculaire, ou encore à l’apprentissage automatique, là où les architectures classiques montrent leurs limites.

La simulation de systèmes quantiques devient envisageable, ouvrant des perspectives inédites : nouveaux matériaux, conception de molécules pour la santé ou l’énergie. Dans la finance ou la logistique, résoudre le problème du voyageur de commerce pourrait bouleverser la planification, la gestion de portefeuilles ou l’analyse de risques. Des acteurs comme Pasqal, Quandela, IonQ, Honeywell ou PsiQuantum rivalisent, chacun misant sur sa technologie de qubits pour prendre l’avantage.

Désormais, le cloud quantique permet à certains chercheurs et entreprises d’accéder à ces calculateurs expérimentaux via internet. Les initiatives européennes, telles que Quantum Flagship, EuroHPC, EuroQCI ou le Plan Quantique, mobilisent toute une filière : scientifiques, ingénieurs, industriels. L’intelligence artificielle s’hybride déjà, conjuguant calcul classique et puissance quantique. Le virage ne sera ni instantané, ni sans difficulté, mais il est amorcé et rien ne semble pouvoir le freiner.

Derrière la révolution quantique, un nouveau territoire s’ouvre. Qui saura en exploiter les codes, en détourner les risques, en écrire les usages ? L’histoire de l’informatique n’a pas fini de s’accélérer.